技术摘要:

本发明公开了基于生成对抗网络的图像超分辨率方法。所述方法包括以下步骤:获取训练数据集、验证数据集;构建图像超分辨率模型,包括生成网络模型和判别网络模型;初始化建立的生成网络模型和判别网络模型的权重,初始化网络模型,选取优化器,设置网络训练的参数;使 全部

背景技术:

在日常的生产生活中,图像是一种重要的信息载体,而图像分辨率是衡量图像质 量的重要标准之一。高分辨率图像包含更多的纹理特征,可以提供更多的信息,因此在生产 生活中人们更希望获取到高分辨率图像。但是由于成像设备的参差不齐、网络传输过程图 像信息的丢失等原因,通过图像超分辨率来提高图像的分辨率成本更低、效果好、更容易实 现。因此图像超分辨率更为实用,对图像超分辨率任务的研究具有重要意义。 图像超分辨率方法主要分为三种:基于插值的、基于重建的和基于学习的。近年 来,深度学习被广泛应用于计算机视觉领域,取得不错的效果,基于深度学习的图像超分辨 率算法也不断提出并取得很好的重建效果和较快的重建速度。董超等人提出的SRCNN首次 将卷积神经网络(CNN)引入到图像超分辨率任务,并取得不错的重建效果。自此,大量基于 CNN的图像超分辨率方法提出,学者通过加深网络来提高网络的重建性能。但是使用均方误 差损失(MSE)来优化网络会使得生成的图像过于平滑,视觉效果差。SRGAN(Ledig C,Theis L ,Huszár F ,et al .Photo-realistic single image super-resolution using a generative adversarial network[A] .In:Proceedings of the IEEE conference on computer vision and pattern recognition[C] ,2017 .4681–4690 .)将生成对抗网络 (GAN)引入到图像超分辨率任务中,利用感知损失和对抗损失等损失函数来监督网络,使得 生成图像具有更好的视觉效果,更加接近于真实图像。ESRGAN(Wang X ,Yu K ,Wu S ,et al.Esrgan:Enhanced super-resolution generative adversarial networks[A] .In: European Conference on Computer Vision[C] ,2018.63–79.)提出使用Residual-in- Residual Dense Block(RRDB)来构建生成网络,使用RaGAN(Jolicoeur-Martineau A.The relativistic discriminator:a key element missing from standard GAN[J].arXiv preprint arXiv:1807.00734,2018.)的判别网络来监督生成网络,生成的图像视觉效果更 好。 但是上述的基于生成对抗网络(GAN)的图像超分辨率方法SRGAN和ESRGAN也存在 一些问题: 1)这些基于GAN的图像超分辨率方法的判别网络往往只输出一个介于[0,1]的概 率值,在整体上判断输入图像是生成的超分辨率图像还是真实高分辨率图像,以此来监督 生成网络来生成更接近真实高分辨率图像的超分辨率图像。但是这种监督是粗糙的,生成 网络不知道生成图像的哪个像素点的重建效果更好,哪个像素点的重建的效果更差。 2)这些基于GAN的图像超分辨率方法通常包含两个独立的网络——生成网络和判 别网络。但是,生成网络和判别网络的浅层部分都是用于提取图像的底层特征,包括边缘, 角点等信息。这两个网络的浅层部分具有相似或者相同的作用,但是却独立在不同的分支 7 CN 111583109 A 说 明 书 2/13 页 中,增加了模型的参数量。其次,生成网络和判别网络在的信息传递上只有对抗损失,判别 网络将对抗损失传递给生成网络,生成网络通过该损失学习生成使判别器分类错误的超分 辨率图像。对抗损失对生成网络的影响是不充分的,不能全面地向生成网络反映出如何更 好地生成靠近真实高分辨率图像的超分辨率图像的。

技术实现要素:

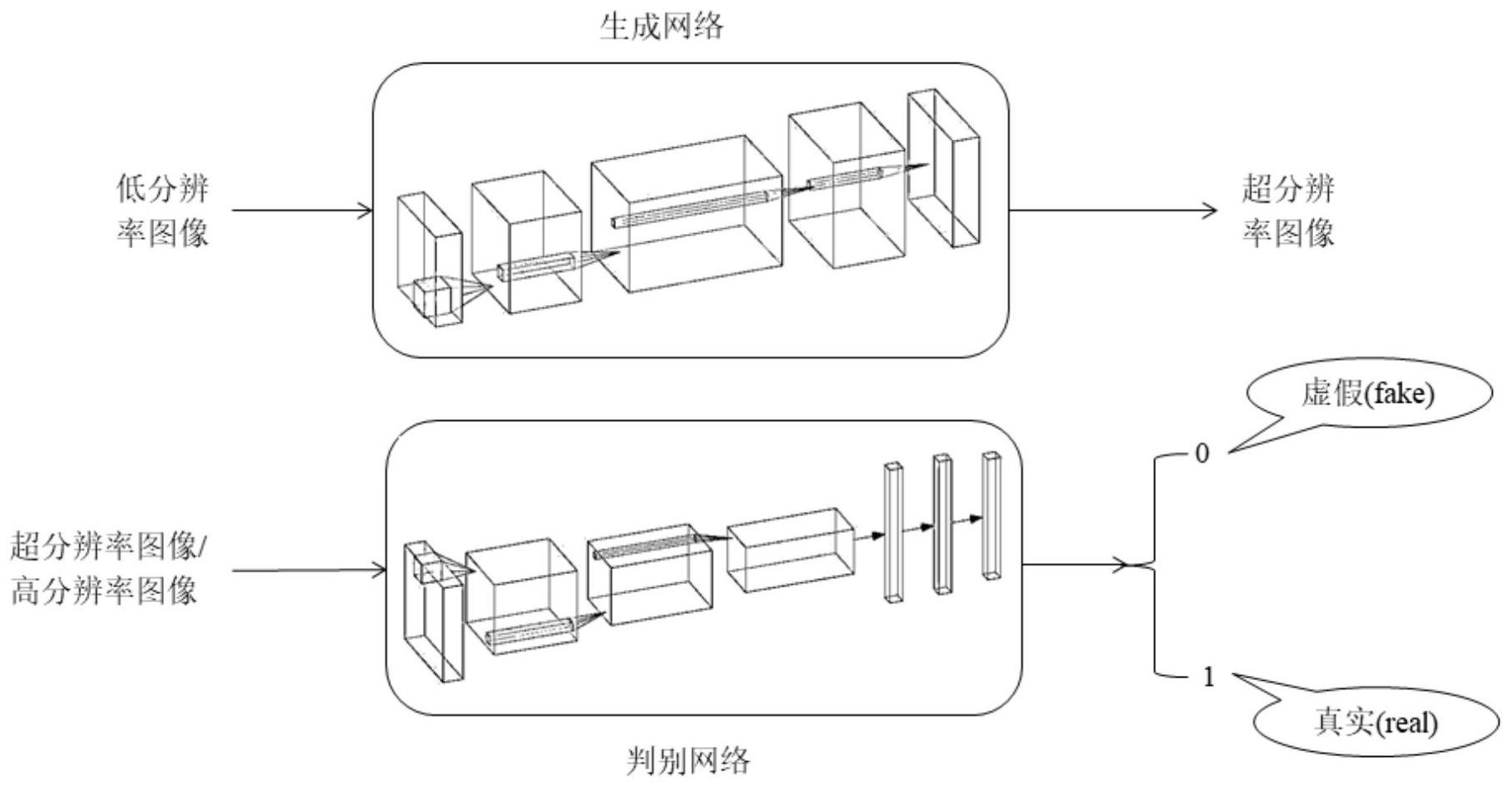

本发明的目的在于解决上述的问题,提供两种改进的基于GAN的图像超分辨率方 法。本发明通过改进的生成式对抗网络来解决图像超分辨率问题,使用判别网络来监督生 成网络,使生成网络生成更接近于真实图像的超分辨率图像。与之前的基于GAN的图像超分 辨率网络比较,本发明能够生成更高质量的超分辨率图像。 本发明的目的至少通过以下技术方案之一实现。 基于生成对抗网络的图像超分辨率方法,包括以下步骤: S1、获取训练数据集、验证数据集; S2、采用两种不同的方法构建图像超分辨率模型,包括生成网络模型和判别网络 模型;所述两种方法包括细粒度注意力机制的基于GAN的图像超分辨率方法(FASRGAN)以及 特征共享的基于GAN的图像超分辨率方法(Fs-SRGAN); S3、初始化步骤S2中建立的生成网络模型和判别网络模型的权重,初始化网络模 型,选取优化器,设置网络训练的参数; S4、首先使用L1损失来训练生成网络模型直到网络收敛,使得生成网络具有较好 的重建图像的能力,保存训练过程中的生成网络模型;加载预训练好的生成网络模型,使用 生成网络和判别网络的损失函数来同时训练生成网络模型和判别网络模型,直到生成网络 和判别网络达到纳什平衡,保存此过程中的生成网络模型和判别网络模型; S5、获取测试数据集; S6、加载训练好的生成网络模型,将测试数据集输入到生成网络模型,生成超分辨 率图像; S7、计算生成的超分辨率图像与真实的高分辨率图像之间的峰值信噪比(PSNR), 计算生成图像的图像重建质量的评价指标,评估图像的重建质量。 进一步地,步骤S1中,采用DIV2K数据集中的若干张2K图像来制作成对的低分辨 率-高分辨率图像作为训练数据集;对原始的2K图像进行下采样处理得到低分辨率图像,与 原始的高分辨率图像构成训练样本对;由于原始的图像尺寸太大,直接输入到网络模型中 进行训练会造成网络模型计算量过大,减慢训练速度,因此对训练图像进行随机剪裁,将低 分辨率图像裁剪为M×K大小的图像块,其中M代表图像块的高度,K代表其宽度,对应的高分 辨率图像裁剪为Mr×Kr,r为放大因子;为了增强训练数据集中数据的多样性和扩展数据 量,将成对的训练数据即低分辨率-高分辨率图像进行翻转和旋转操作,包括90°、180°和 270°; 所述验证数据集采用Set5数据集,由5张图像组成,在网络训练过程用于评估生成 网络的重建性能,利于观察生成网络模型的收敛程度。 进一步地,步骤S2中,细粒度注意力机制的基于GAN的图像超分辨率方法中,所述 的判别网络模型采用Unet结构,上分支与传统的判别网络模型具有相同的结构,利用步长 8 CN 111583109 A 说 明 书 3/13 页 为2的池化层来减少特征图的空间大小,扩大感受野;经过R次池化层,特征图的空间大小变 为原来的 倍;每个池化层后跟随两个卷积层,提取特征。在特征图最小的情况下使用两个 全连接层输出图像的整体统计特征,即判别网络模型对输入图像整体上的判别,1代表输入 的是真实图像,而0代表输入的是生成图像; 所述判别网络模型的下分支采用不断上采样的方式,逐步扩大特征图的空间大 小,将上分支与下分支具有相同大小的特征图进行串联,利于判别网络模型中的信息流动 和对下分支中浅层次特征的充分利用;每个上采样后的特征图经过两个卷积层处理;下分 支最终输出一个与输入图像大小相同的掩码图(Mask map),表示判别网络模型对输入图像 的每个像素的判别信息,其中,该像素上的值越接近于1代表该像素与真实图像的对应像素 越相似,反之越不相似;将此掩码图加入到生成网络模型的损失函数中,使生成网络模型关 注于重建得不好的像素,监督生成网络模型去重建出更高质量的超分辨率图像;判别网络 模型的损失函数包括两个部分:对抗损失和细粒度的attention损失,公式如下: 表示对抗损失,采用RaGAN中的损失函数,公式如下: 其中,xr和xf代表真实图像和生成图像,σ是sigmoid函数,C(x)指判别网络中 sigmoid函数之前的输出,DRa代表判别网络的函数, 代表对批数据量中所有的假数据求 期望的操作,而 代表对批数据量中所有的真实数据求期望的操作,所述假数据为生成图 像,所述真实数据为真实图像; 表示细粒度的attention损失,公式如下: 其中,Mr和Mf分别代表了真实图像和生成图像的掩码图,W、H、C分别代表输入到生 成网络模型的低分辨率图像的宽度、长度和通道数目,r为放大因子,则生成网络模型的输 出图像的宽度为Wr,而长度为Hr。 进一步地,步骤S2中,细粒度注意力机制的基于GAN的图像超分辨率方法中,所述 生成网络模型采用RRDB(Residual-in-Residual Dense Block)作为基础模块,通过以线性 串联的方式来堆叠A个RRDB来构建深层的网络结构,重建出高质量的超分辨率图像;生成网 络模型的损失函数如下: LG=L1 λadv*Ladv λattention*Lattention λpercep*Lpercep; 其中,λadv、λattention、λpercep代表平衡不同损失函数项的系数; Lattention表示细粒度的attention损失,公式如下: 9 CN 111583109 A 说 明 书 4/13 页 其中,Mf是判别网络模型络生成的超分辨率图像的掩码图(Mask map),Mf(w,h,c) 表示生成图像ISR(w,h,c)与真实图像之间的每个像素的差异,使用1-Mf(w,h,c)的方法来给 图像的每个像素分配不同的权重,使得与真实图像分布差异较大的像素受到更多的关注; L1表示内容损失,约束生成图像在内容上更加接近于真实图像,公式如下: 其中, 代表生成网络模型G的函数,θ是生成网络模型的参数,在迭代训练过程 进行优化;W、H、C分别代表输入到生成网络模型的低分辨率图像的宽度、长度和通道数目,r 为放大因子,i为批数据量中的第i张图像; Lpercep表示感知损失,目的是使生成图像在高阶的特征层面上与对应的高分辨率 图像接近,采用预训练的VGG19网络的第54层的特征来计算感知损失,公式如下: 其中 是指预训练的VGG19网络的函数,G表示生成网络模型, 和 分别是 第i张低分辨率图像和高分辨率图像; Ladv表示对抗损失,生成网络模型需要重建出使判别网络模型难以判别出是生成 图像的超分辨率图像,因此其公式与判别网络模型的对抗损失相反,具体如下: 进一步地,步骤S2中,特征共享的基于GAN的图像超分辨率方法中,将生成网络和 判别网络的浅层特征提取模块协同起来,减少模型的参数;生成网络和判别网络共同优化 浅层特征提取模块,有利于提取出更加有效的特征;共用的浅层特征提取模块采用特征图 的大小不变的全卷积神经网络,公式如下: Hshared=Fshared(x); 其中Fshared代表共用的浅层特征提取模块的函数,Hshared代表浅层特征提取模块所 输出的特征图,x指的是输入到浅层特征提取模块的特征图。 进一步地,特征共享的基于GAN的图像超分辨率方法中,所述生成网络模型包括浅 层特征提取模块、深层特征提取模块和重建模块;其中,深层特征提取模块的基础模块与浅 层特征提取模块的相同;浅层特征提取模型由S个RRDB构成,而深层特征提取模块由D个 RRDB通过线性串联的方式堆叠而成,D>S,用于提取更多的抽象特征和高频特征,为重建出 高质量的超分辨率图像提供重要信息;重建模块通过上采样层来将特征图放大到指定的尺 寸,使用卷积层重建出超分辨率图像; 生成网络模型的损失函数包括对抗损失、内容损失和感知损失,如下: 10 CN 111583109 A 说 明 书 5/13 页 LG=L1 λadv*Ladv λpercep*Lpercep; λadv和λpercep代表平衡不同损失函数项的系数; L1表示内容损失,约束生成图像在内容上更加接近于真实图像,公式如下: 其中, 代表生成网络模型G的函数,θ是生成网络模型的参数,在迭代训练过程 进行优化;W、H、C分别代表输入到生成网络模型的低分辨率图像的宽度、长度和通道数目,r 为放大因子,i为批数据量中的第i张图像; Lpercep表示感知损失,目的是使生成图像在高阶的特征层面上与对应的高分辨率 图像接近,采用预训练的VGG19网络的第54层的特征来计算感知损失,公式如下: 其中 是指预训练的VGG19网络的函数,G表示生成网络模型, 和 分别是 第i张低分辨率图像和高分辨率图像; Ladv表示对抗损失,生成网络模型需要重建出使判别网络模型难以判别出是生成 图像的超分辨率图像,因此其公式与判别网络模型的对抗损失相反,具体如下: 进一步地,特征共享的基于GAN的图像超分辨率方法中,所述判别网络模型是一个 分类网络,需要使用更大的感受野去获取图像在整体上的抽象特征;使用类似VGG网络的结 构作为判别网络模型,判别网络模型由N个卷积层组合和一个线性分类器组成,所述卷积层 组合是由卷积核为3的一层卷积和卷积核为4,步长为2的卷积层组成的;为了减少信息的损 失,判别网络模型使用了步长为2的卷积层来替代池化层,从而减小特征图的大小;为了保 持较好的特征表达能力,在减小特征图的同时增加通道的数目;最后,将特征图变为一维的 向量,并通过两层的全连接网络输出对输入图像判别的分类值,其中0表示生成图像 (fake),1表示真实图像(real); 判别网络模型的损失函数为对抗损失,具体如下: 其中,xr和xf代表真实图像和生成图像,σ是sigmoid函数,C(x)指判别网络中 sigmoid函数之前的输出,DRa代表判别网络的函数, 代表对批数据量中所有的假数据求 期望的操作,而 代表对批数据量中所有的真实数据求期望的操作,所述假数据为生成的 超分辨率图像,所述真实数据为真实的高分辨率图像。 进一步地,步骤S3中,对所述生成网络模型和判别网络模型中的所有卷积层采用 kaiming_normal来初始化其权重;选取Adam作为网络训练时的优化器; 所述网络训练的参数包括:指定训练数据集和验证数据集的路径、指定放大因子 11 CN 111583109 A 说 明 书 6/13 页 r、输入到网络的批数据量、初始学习率Lr_initial;ADAM优化器的参数、生成网络和判别网 络的损失函数中各项损失函数的系数以及训练的迭代次数niter。 迭代训练的过程中,生成网络模型和判别网络模型的损失函数的收敛曲线可能会 产生震荡,表明当前的学习率过大,因此,在同时训练生成网络模型和判别网络模型时,每 隔lr_step步将学习率减半,加速生成网络模型和判别网络模型的收敛速度,提高生成网络 模型的重建性能和判别网络模型的判别性能;在训练过程中使用ADAM优化器来对生成网络 模型和判别网络模型的梯度进行反向传播,不断更新两个模型的权重。 进一步地,步骤S4中,在网络训练的初期使用多个损失函数训练会使得网络训练 动荡,损失函数的曲线难以收敛;因此,首先采用L1损失对生成网络模型进行预训练,得到 预训练好的生成网络模型。训练过程中采用ADAM优化器进行梯度的反向传播,更新参数;初 始学习率为lr_G,迭代次数为niter_G,每隔lr_step_G次迭代对学习率进行减半,加快生成 网络模型的收敛和提高生成网络模型的重建性能;接着使用上述的生成网络的损失函数和 判别网络的损失函数来同时训练生成网络模型和判别网络模型;当生成网络模型和判别网 络模型达到纳什平衡时,生成网络模型生成的超分辨率图像,使得判别网络模型不能区分 出是生成的超分辨率图像还是真实的高分辨率图像; 步骤S5中,测试数据集采用图像超分辨率任务中常见的测试数据集Set5、Set14、 Urban100、BSD100、Manga109和DIV2K验证集测试数据集。 进一步地,步骤S7中,采用根均方误差(RMSE)和感知指数(PI)作为图像重建质量 的评价指标,将图像转到YCbCr空间,在Y通道上进行计算根均方误差或者峰值信噪比PNSR。 其中H、W为低分辨率图像的长度和宽度,r为放大因子,X为真实图像, 为生成的 超分辨率图像。 MSE为均方误差,n为每像素的比特数;PSNR的单位是分贝(dB),数值越大表示失真 越小,重建质量越好; 其中Ma(Ma C ,Yang C Y ,Yang X ,et al .Learning a No-Reference Quality Metric for Single-Image Super-Resolution[J] .Computer Vision and Image Understanding ,2017 ,158:1-16)与NIQE(Mittal A ,Fellow ,IEEE ,et al .Making a ' Completely Blind 'Image Quality Analyzer[J] .IEEE Signal Processing Letters , 2013 ,20(3):209-212 .)是两个无参考图像测量方式,用于感知质量评估;PI被用来作为 2018PIRM Challenge on Perceptual Image Super-Resolution(Blau Y ,Mechrez R , Timofte R,et al.The 2018 PIRM Challenge on Perceptual Image Super-Resolution [A].In European Conference on Computer Vision[C],2018.7794-7803.)的评价指标之 一;PI与人类对图像的主观评价有相关性,数值越小,在一定程度上反映了图像越具有感知 12 CN 111583109 A 说 明 书 7/13 页 质量,为了保证重建的超分辨率图像在内容上与真实的高分辨率图像相似,PI通常需要与 MSE结合来评价重建图像的质量。 相比于现有技术,本发明的优点在于: 1)本发明提出了基于生成对抗网络的图像超分辨率方法,包括细粒度注意力机制 的基于GAN的图像超分辨率方法(FASRGAN)和特征共享的基于GAN的图像超分辨率方法(Fs- SRGAN)。其中FASRGAN采用Unet结构来构建判别网络,使其输出一个在整体图像上判断输入 图像是生成的图像还是真实的图像的介于[0,1]的分类值,和一个在像素层面上判断输入 图像在每个像素上与真实的图像之间的差异的掩码图(Mask map)。将Mask map加入到生成 网络模型的损失函数中,使生成网络更加关注于重建图像中效果较差的部分,从而重建出 质量更好的超分辨率图像。Fs-SRGAN将生成网络和判别网络的浅层特征提取部分进行共 享,使得这两个网络共用一个浅层特征提取模块,在减少生成网络模型和判别网络模型的 参数量的同时,让生成网络和判别网络的损失函数来共同优化该浅层特征提取模块,有利 于该模块提取到对生成网络和判别网络更加有效的特征,从而提高生成网络的重建能力。 2)本发明通过优化网络结构来提升网络重建超分辨率图像的性能,解决图像超分 辨率问题,并且取得比当前主流的图像超分辨率方法更好的重建效果。 附图说明 图1基于生成对抗网络(GAN)方法的图像超分辨率方法的网络模型,生成网络 (Generator)包括浅层特征提取模块、深层特征提取模型、重建模块,重建高质量的超分辨 率图像,而判别网络(Discriminator)包含浅层特征提取、深层抽象特征表示、分类器,判别 输入图像为真实高分辨率图像(real)还是虚假的生成图像(fake); 图2本发明的训练流程图与测试流程图; 图3为细粒度注意力机制的基于GAN的图像超分辨率方法(FASRGAN)的判别网络, 其中,K、S、G分别表示卷积层中卷积核大小、卷积步长和通道数; 图4为特征共享的基于GAN的图像超分辨率方法(Fs-SRGAN)的网络模型; 图5为本发明提出的两个基于GAN的图像超分辨率方法的网络训练方式和步骤; 图6为本发明中的FASRGAN与当前流行的图像超分辨率方法在放大因子为4时的结 果示意图; 图7为本发明中FASRGAN的消融实验结果示意图,去掉细粒度注意力机制; 图8为当放大因子为4时,本发明中Fs-SRGAN与当前流行的图像超分辨率方法的视 觉对比图; 图9为本发明中Fs-SRGAN的消融实验结果示意图,去掉特征共享机制; 图10为在放大因子为4时,本发明中提出的两种方法与当前流行的图像超分辨率 方法在数据集Urban100中均方根误差(RMSE)与感知指标(PI)之间的权衡,其中FA Fs-GAN 将本发明中的细粒度注意力机制和特征共享机制融合到同一个基于GAN的图像超分辨率模 型中; 图11为本发明训练过程中,当放大因子为4时,本发明方法在Set14数据集上平均 PI值的变化曲线,其中FA Fs-GAN将本发明中的细粒度注意力机制和特征共享机制融合到 同一个基于GAN的图像超分辨率模型中。 13 CN 111583109 A 说 明 书 8/13 页