技术摘要:

本发明公开了一种基于信息增强的目标检测方法,目的是解决单阶段检测方法精度低的缺点。技术方案是构建由特征提取模块、语义提升模块、特征选择模块、特征融合模块、检测模块构成的目标检测系统,采用训练数据集对目标检测网络进行训练,采用训练后的目标检测系统对单 全部

背景技术:

目标检测是计算机视觉领域重要的研究方向之一,传统的目标检测方法是通过对 一定区域内的图像构建特征描述子(如方向梯度直方图等)提取特征,然后利用分类器对特 征进行分类实现目标检测,如支持向量机SVM(Support Vector Machine)等。近来随着卷积 神经网络的发展,工程特征大部分已经被卷积神经网络特征所取代,目标检测系统在精度 和速度上都取得了很大的进步。 当前,基于深度学习的目标检测方法分为双阶段检测方法和单阶段检测方法。 双阶段检测方法采用Fast R-CNN、Faster R-CNN、R-FCN双阶段网络,首先对输入 图片提取候选区域,然后对提取的候选区域进行分类和定位。目前,该类方法达到了检测精 度非常好的效果,但是存在速度较慢的缺点,达不到实时性的要求。 单阶段检测方法采用SSD(Single Shot MultiBox Detector,单阶段多参考窗口 检测器)等单阶段网络直接对设置的默认框进行定位和分类,省略了双阶段方法中提取候 选区域的操作,检测速度得到了提升,但是检测精度较双阶段方法略有下降,尤其是对小尺 寸目标的检测。出现这种情况主要是因为面向小尺寸目标检测的低层特征的卷积层数少, 语义信息不够丰富,导致小目标的检测效果仍然不尽如人意。 FPN(见文献“Lin ,Tsung-Yi ,et al .Feature pyramid networks for object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.2017”,Lin Tsung-Yi的论文:目标检测特征金字塔网络)网络通过 侧向连接将高层特征丰富的语义逐层传递给低层特征,Libra r-cnn(见文献“Pang , Jiangmiao ,et al.Libra r-cnn:Towards balanced learning for object detection [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2019”,Pang Jiangmiao的论文:针对目标检测的平衡学习)网络通过特征相 加求均值的方法使每层特征都获得了其他所有特征的信息。采用了FPN和Libra r-cnn网络 进行特征融合的目标检测方法都是将已有特征直接进行结合,没有经过筛选以抑制无用的 信息、增强有用的信息,无法达到很好的融合效果,因此检测精度仍然比较低。 因此,如何充分利用全局信息,在不降低单阶段检测方法速度的同时,提供一种检 测精度更高的目标检测方法,是本领域技术人员正在探讨的热点问题。

技术实现要素:

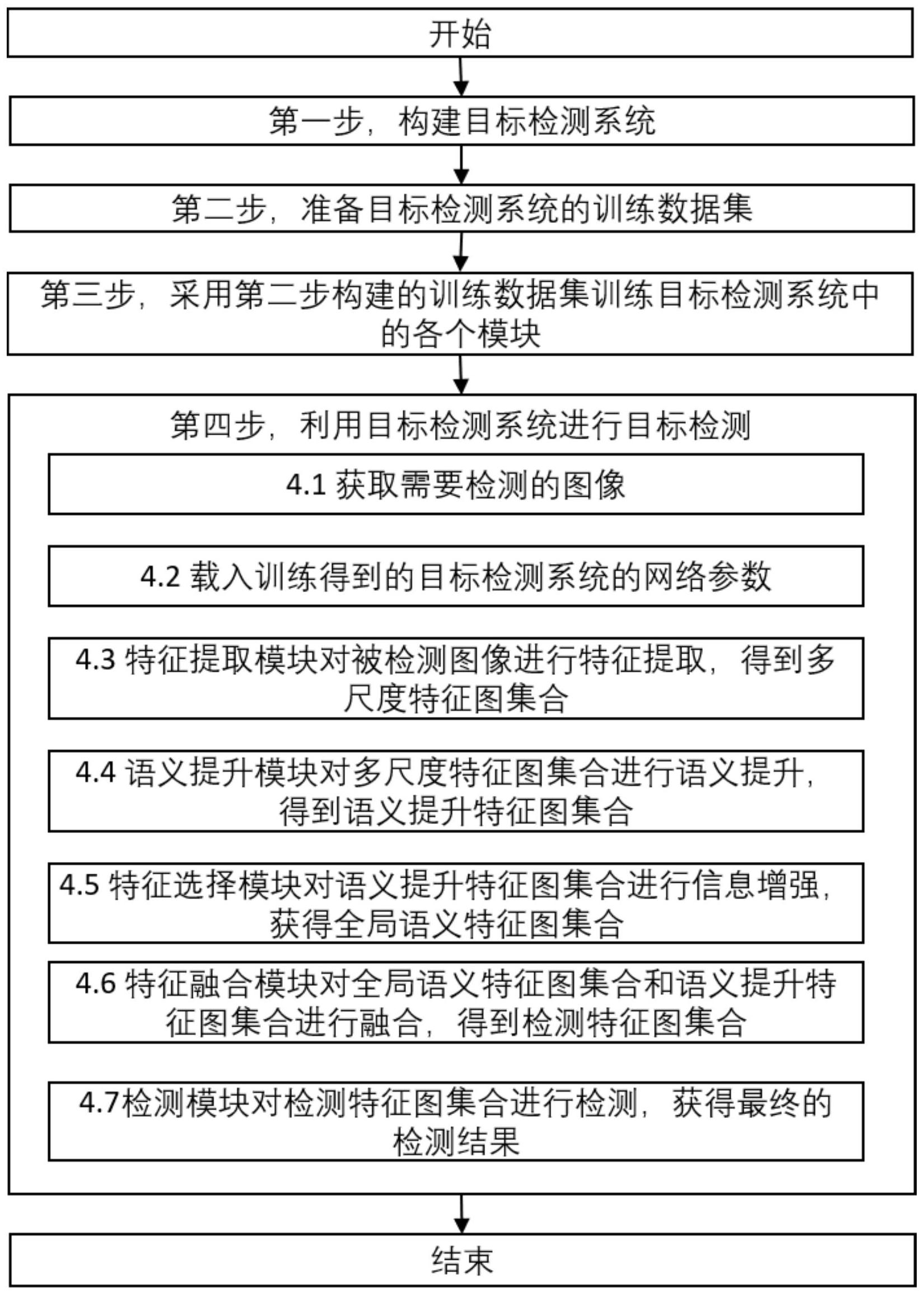

本发明要解决的技术问题是解决目前单阶段检测方法虽然检测速度快,但精度低 的缺点。 本发明提供一种基于信息增强的目标检测方法,在单阶段SSD网络中加入注意力 8 CN 111612017 A 说 明 书 2/14 页 机制,达到提升目标检测尤其是小目标检测精度的目的。 为解决上述技术问题,本发明的技术方案是:首先构建由特征提取模块、语义提升 模块、特征选择模块、特征融合模块、检测模块构成的目标检测系统。然后选择PASCAL VOC 2007、PASCAL 2012的训练集和验证集的组合数据集作为对目标检测网络进行训练的训练 数据集,拟合后得到目标检测系统的网络参数。最后采用训练后的目标检测系统对单帧图 像进行特征提取、语义提升、特征选择、特征融合,识别目标的位置和类别。 本发明主要包括以下具体步骤: 第一步:构建目标检测系统。该系统由特征提取模块、语义提升模块、特征选择模 块、特征融合模块、检测模块组成。 特征提取模块为一个卷积神经网络,与语义提升模块相连。特征提取模块共包括 23个卷积层,5个池化层,共28层。池化层分别为第3、6、10、14、18层,其他层均为卷积层。特 征提取模块接收图像I,对图像I进行特征提取,得到多尺度特征图集合F(I),将F(I)发送给 语义提升模块。多尺度特征图集合包含六个尺度的特征图,六个尺度的特征图的尺寸分别 为38×38×512,19×19×1024,10×10×512,5×5×256,3×3×256,1×1×256,分别由第 13层、第21层、第23层、第25层、第27层、第28层输出给语义提升模块。其中,第13层、第21层、 第23层、第25层、第27层特征既输出给语义提升模块,也输出给它们各自的下一层。(即,第 13层将尺寸为38×38×512的特征图输出给语义提升模块和第14层;第21层将尺寸为19× 19×1024的特征图输出给语义提升模块和第22层;第23层将尺寸为10×10×512的特征图 输出给语义提升模块和第24层;第25层将尺寸为5×5×256的特征图输出给语义提升模块 和第26层;第27层将尺寸为3×3×256的特征图输出给语义提升模块和第28层;第28层将尺 寸为1×1×256的特征图输出给语义提升模块。)特征图的尺寸的含义是:前两个维度是特 征图中每个通道中的像素长和宽,第三个维度为通道数。以尺寸为10×10×256的特征图为 例,256为通道数,前两个维度是特征图中每个通道中的像素点的坐标。 语义提升模块包含一个1×1卷积层和一个ReLU激活函数(见文献“Krizhevsky , Alex,et al.ImageNet Classification with Deep Convolutional Neural Networks [C]//Advances in neural information processing systems,2012”,Krizhevsky,Alex 的论文:ImageNet分类与深度卷积神经网络),与特征提取模块、特征选择模块、特征融合模 块相连。语义提升模块的1×1卷积层从特征提取模块接收F(I),对F(I)中的6个特征图逐张 进行卷积操作,将F(I)中的6个特征图的第三个维度统一为256,得到S'(I),将S'(I)发送给 ReLU激活函数;ReLU激活函数从1×1卷积网络接收到S'(I),对S'(I)进行激活操作,以提升 特征的语义信息,得到S(I),将S(I)输出给特征选择模块和特征融合模块。S(I)包含的特征 图尺寸分别为38×38×256,19×19×256,10×10×256,5×5×256,3×3×256,1×1× 256。 特征选择模块与语义提升模块、特征融合模块相连,对S(I)进行选择性地融合,得 到全局特征图集合G(I),将G(I)发送给特征融合模块。特征选择模块由第一变形模块、第一 特征图相加模块、全局池化模块、非线性增加模块、特征生成模块(含6个注意力模块、归一 化模块、通道赋权模块)、第二特征图相加模块、第二变形模块组成。 第一变形模块是对S(I)进行插值和下采样操作的模块,与语义提升模块和第一特 征图相加模块相连;对S(I)中的特征图进行上采样或插值操作,统一特征图的尺寸,得到A1 9 CN 111612017 A 说 明 书 3/14 页 (I),将A1(I)发送给第一特征图相加模块,A1(I)包含的6个特征图尺寸都为10×10×256,由 于缩小特征图会损失信息,在没引入较大计算量的前提下,为了减少特征图的信息损失,统 一将特征图尺寸调整至10×10×256。 第一特征图相加模块与第一变形模块和全局池化模块连接,对A1(I)中的六个特 征图执行像素级别的加法操作,获得尺寸为10×10×256的第一全局特征图,记为I2,将I2发 送给全局池化模块。 全局池化模块和第一特征图相加模块和非线性增加模块相连,对I2进行全局池化 操作,获得第一一维向量A3(I),将A3(I)发送给非线性增加模块。A3(I)中共有256个元素。 非线性增加模块包含一个全连接层和一个ReLU激活函数,与全局池化模块、特征 生成模块相连,对A3(I)采用全连接操作,以降低模型复杂度,得到包含16个元素的激活前 向量A4(I) ',将A4(I) '发送给ReLU激活函数;ReLU激活函数从全连接层接收到A4(I) ',对A4 (I) '进行激活操作,提升A4(I) '的非线性,得到第二一维向量A4(I),A4(I)中包含16个元素, 将A4(I)发送给特征生成模块。 特征生成模块和非线性增加模块、第二特征图相加模块相连。特征生成模块由6个 注意力模块、1个归一化模块和1个通道赋权模块组成。6个注意力模块均为一层全连接层。 注意力模块是一种注意力模型,注意力模型可以宏观上理解为一个查询(Query)到一系列 (键Key-值Value)对的映射。将Source(源)中的构成元素想象成由一系列的