技术摘要:

本发明提供一种基于OpenStack架构的GPU云服务器实现方法,属于云计算技术领域,首先选择资源特定配置的GPU物理机,把GPU物理机上架到OpenStack的计算节点,并按照GPU卡配置GPU物理机对应的主机聚合和云主机规格Flavor,然后配置OpenStack的调度算法、控制节点和计算节 全部

背景技术:

30年来,CPU性能的变化从未脱离摩尔定律。但是CPU性能的提升已经放缓,GPU计 算定义了一种全新的超负荷定律。它始于高度专业化的并行处理器,通过系统设计、系统软 件、算法以及优化应用程序的方式持续发展,尤其适用于日益增长的人工智能、HPC以及图 形图像处理等应用场景的算力需求。 裸金属形式的GPU云物理主机能提供“一机多卡”或“多机多卡”的算力。但是部分 用户,多张GPU卡超出了用户的算力需求,用户需要更细颗粒度的GPU算力,例如1张GPU卡。 所以,需要将宿主机中的GPU卡虚拟化后分配给用户云服务器,而单独的云服务器并不能满 足日益增长的人工智能、HPC以及图形图像处理等应用场景的算力。

技术实现要素:

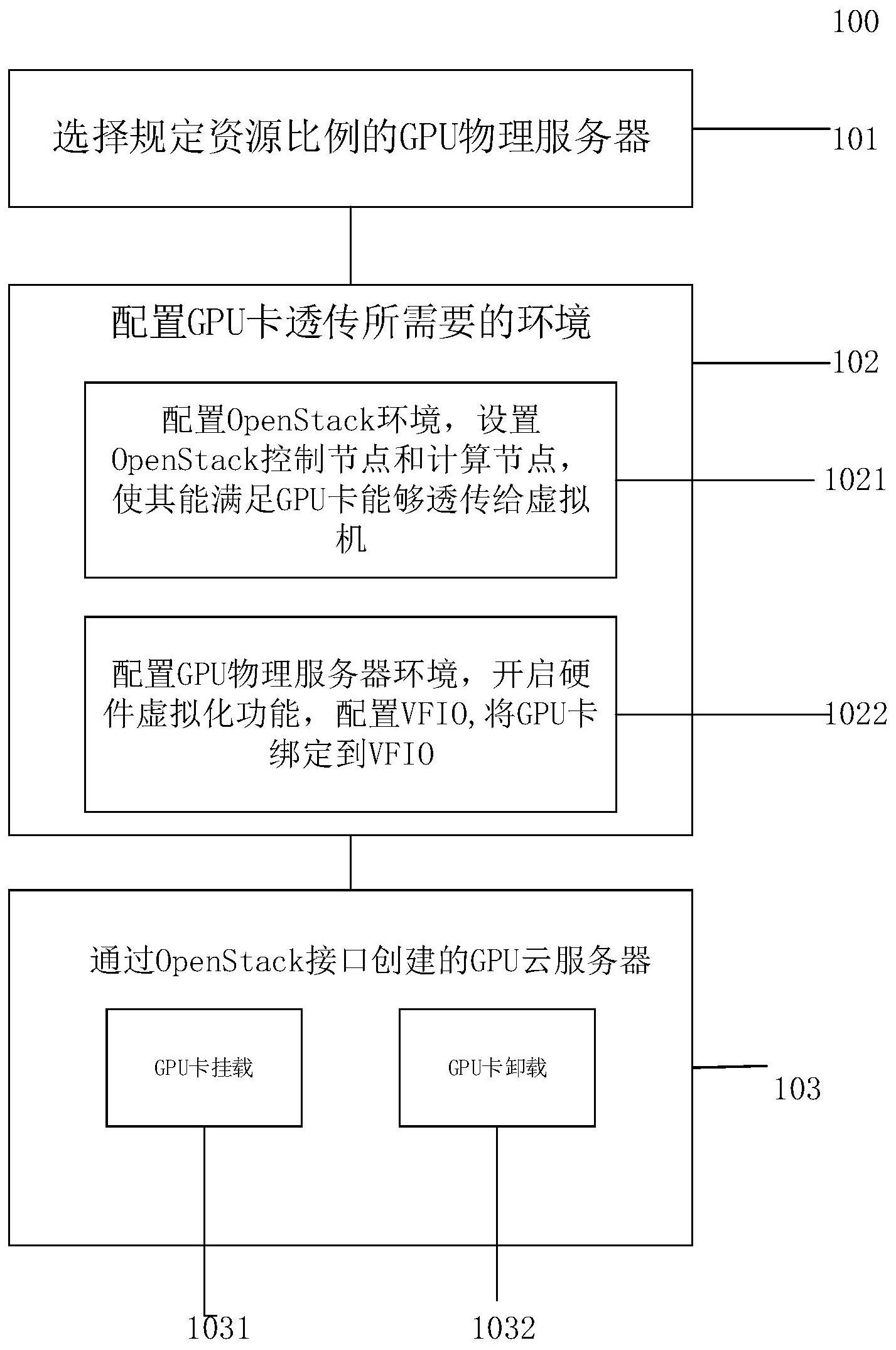

为了解决以上技术问题,本发明提供了一种基于OpenStack架构的GPU云服务器实 现方法,通过OpenStack平台把物理GPU卡透传给云服务器,解决了上面存在的问题。 本发明的技术方案是: 一种基于OpenStack架构的GPU云服务器实现方法,包括如下步骤: 1)选择规定资源比例的GPU物理服务器; 2)配置GPU卡透传所需要的环境; 3)通过OpenStack接口创建的GPU服务器。 进一步的, 所述步骤2)具体包括: 2.1)配置OpenStack环境,设置OpenStack控制节点和计算节点,使其能满足GPU卡 能够透传给虚拟机; 2 .2)配置GPU物理服务器环境,开启硬件虚拟化功能,配置VFIO,将GPU卡绑定到 VFIO。 所述步骤4)包括GPU卡的挂载和卸载。 第一方面,创建的云服务器规格内的GPU,VCPU,内存,存储最大值或者多种规格相 加的资源值都不能超过此选择的GPU物理服务器的资源,并留出部分CPU、内存和存储资源 用于管理。 第二方面,GPU物理服务器配置首先需要把GPU物理服务器硬件的辅助虚拟化功能 开启,再确认PCI设备(GPU卡)驱动信息并从host默认驱动程序中解绑,并把默认的 OpenStack驱动nouveau加入到黑名单中,并设置VFIO并隔离用于直通的GPU,并将GPU卡绑 定到VFIO;其中OpenStack配置的方法,首先配置控制节点的默认配置文件开启PCI直通过 3 CN 111611078 A 说 明 书 2/3 页 滤器,并配置PCI别名(alias)来区分GPU卡信息,再配置计算节点把GPU卡信息添加到透传 白名单(passthrough_whitelist)和设置卡信息到别名(alias),并把主机过滤器的权重只 设置为PCI。 第三方面,主机聚合设置为将GPU物理服务器的主机聚合按照服务类型和GPU卡的 信息设置添加标签;其中设置规格Flavor的方法包括设置Flavor的名称按照服务类型-CPU 内存存储和显卡信息,并设置Flavor额外配置添加PCI透传的显卡信息和数量和服务类型 标签和主机聚合一样。 本发明的有益效果是 本发明采用了OpenStack架构的内GPU卡的直通方式给云服务器的方法,减少了 GPU物理服务器的资源浪费和云服务器算力不足的问题,同时采用了主机聚合分类的方法, 能更好的管理机器和优化机器的调度算法。 附图说明 图1是本发明总的流程图; 图2是根据本发明创建GPU云服务内主机聚合和规格选择过滤机器的示意图; 图3是根据本发明GPU卡透传云服务器的示意图。